La publicación de un nuevo sitio web en un dominio que alberga un sitio web bien posicionado, puede suponer un importante revés en el SEO del mismo si no se tienen en cuenta factores determinantes en su visibilidad. A continuación presentamos un listado de los Errores SEO más frecuentes en la publicación de un sitio web.

¿Cuáles son los problemas SEO en la publicación de una nueva web?

Son variados los problemas que el SEO puede encontrar al publicar una nueva web, que pueden provocar que el proyecto SEO tenga un mal comienzo.

Permitir indexación durante el desarrollo de la web

Que el desarrollador de la web no restrinja el acceso a Google durante su labor de creación de la web, no va a agilizar el trabajo de indexación una vez que la web esté finalizada. Todo lo contrario, permitir que Google rastree nuestro sitio web durante el desarrollo de este, puede ser un mal comienzo para el SEO. Google puede detectar contenido duplicado, escaso contenido, y un rastreo de multitud de páginas de pruebas que luego dejarán de existir y contarán como páginas no encontradas entre otras cosas.

URLs amigables

No dejar configuradas las URLs amigables no está bien visto en el SEO y mucho menos por Google que todo lo que persigue es darle mucha información de valor al usuario que usa sus motores de búsqueda. Las palabras clave en la URL también son importantes para mejorar la optimización On-Page.

Redireccionamientos y URLs canónicas

Tener el mismo contenido por ejemplo con www y sin www, es algo que Google interpreta como contenido duplicado. Para evitarlo debemos crear redirecciones 301.

No realizar un adecuado test final

Creer que todo está listo y confiar en que nada falla sin revisar si el contenido es el correcto y no tenga faltas de ortografías, no comprobar que todos los enlaces funcionan bien, no probar la usabilidad y el diseño en la versión móvil, si hubiese traducciones, comprobar que estas son correctas, que los formularios envían toda la información completa correctamente, que las páginas que sobran se han borrado, que se ha optimizado toda la web y examinado las velocidades de carga, etc.

No realizar una auditoría de SEO técnico

Con una auditoría SEO técnico sobre el sitio web podemos encontrar problemas que habríamos pasado por alto. Por eso es bueno contar con la ayuda de herramientas de auditoría web y analizar a nuestro sitio en busca de posibles errores que pasan desapercibidos, por ejemplo páginas de peso elevado, text alt vacíos, errores 404, etc.

Siempre se nos puede escapar algún detalle incluso si estamos optimizando página por página. Por eso es recomendable el uso de programas de auditoría SEO.

Inexistencia de Robots.txt y Sitemaps

Es común la práctica de finalizar una web y no enviar su contenido a Google a través de la herramienta Search Console. También es importante en este caso que se haya quitado ya la restricción de indexación por los motores de búsquedas que se activó durante el desarrollo de la web.

Es importante la inclusión de estos archivos a la hora de lanzar la web puesto que estamos dando a los buscadores una idea clara y estructurada de nuestro sitio web y al mismo tiempo estamos bloqueando páginas que no queremos que sean indexadas.

No eliminar el contenido que no va a ser usado

Cuando montamos una web (Sobre todo en WordPress) instalamos temas que suelen importar gran cantidad de imágenes o páginas de muestra que, a pesar de no ser accesibles desde el menú de navegación, están incrustadas en el sitemap y por lo tanto son rastreadas por Google dejando que interprete que parte de nuestro contenido es duplicado ya que otros webmasters probablemente estén cometiendo el mismo error que nosotros. Asimismo, estamos malgastando el Crawl Budget de nuestra web.

Caso práctico: Solución de problemas

Evitar la indexación durante el desarrollo de la web:

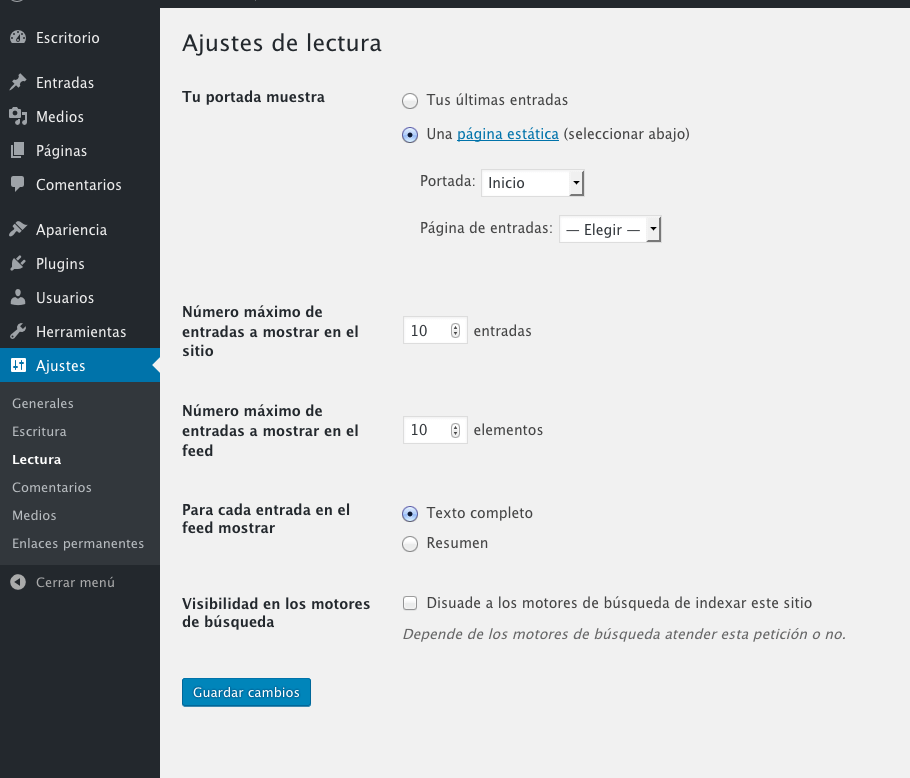

Desde WordPress podemos bloquear la indexación de nuestra web de un modo muy sencillo:

Entramos en el Escritorio / Ajustes / Lectura y activamos la opción de «Disuade a los motores de búsqueda de indexar este sitio»

Ya podemos realizar cambios en la web sin que Google esté revisando el contenido en intentando indexarlo.

Usar URL Amigables:

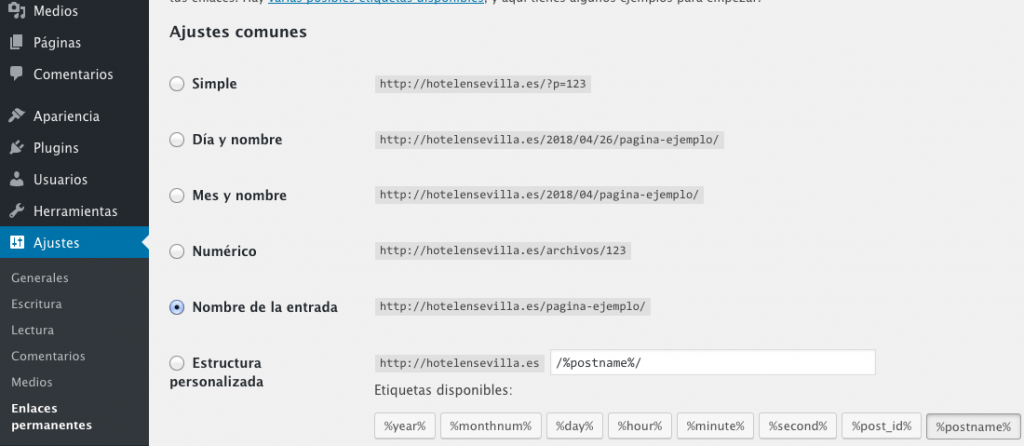

Debido a que estamos usando un CMS (WordPress) este nos asigna la URL de nuestras páginas automáticamente, aunque lo podemos cambiar con facilidad, siempre se nos puede olvidar y acabar publicando una página o entrada con esta URL:

https://midominio.com/?p=123

Esta clase de URLs no aportan nada al usuario ya que no pueden identificar el contenido que hay en su interior.

Sin embargo esto es lo que se considera una URL amigable.

https://midominio.com/pagina-ejemplo/

Podemos configurarlas de un modo muy sencillo. Vamos a Ajustes / Enlaces permanentes y seleccionar la versión que más nos guste:

Redireccionamientos y URL canónicas:

Respecto a la versión con y sin «www», WordPress se encarga de redireccionarla automáticamente según la versión preferida que tengamos establecida. (Ajustes / Generales)

En cuanto a la versión sin SSL y con SSL podemos instalar el plugin Really Simple SSL y nos creará la redirección de todo el sitio de http a https de forma dinámica. También podemos escribir nosotros la regla en htaccess.

Realizar auditoría SEO:

Desde programas como WebSite Auditor podemos conseguir un reporte completo del estado de la web y así conocer que posibles errores hemos pasado por alto para solucionarlos antes de publicar la web.

Robots.txt y Sitemaps

Al instalar un WordPress el robots.txt es creado automáticamente y el sitemap también por el plugin de Yoast SEO.

En caso de no estar usando un WordPress, podemos usar WebSite Auditor para generar ambos archivos.

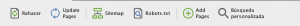

En el menú superior de Website auditor encontramos ambas opciones para poder generar los archivos:

Para el Sitemap: Solo debemos hacer clic y seleccionar que páginas queremos integrar en nuestro sitemap, elegir la frecuencia de actualización y la prioridad de cada página. Lo guardamos en nuestro escritorio y posteriormente lo subimos mediante FTP a la raíz de nuestro sitio.

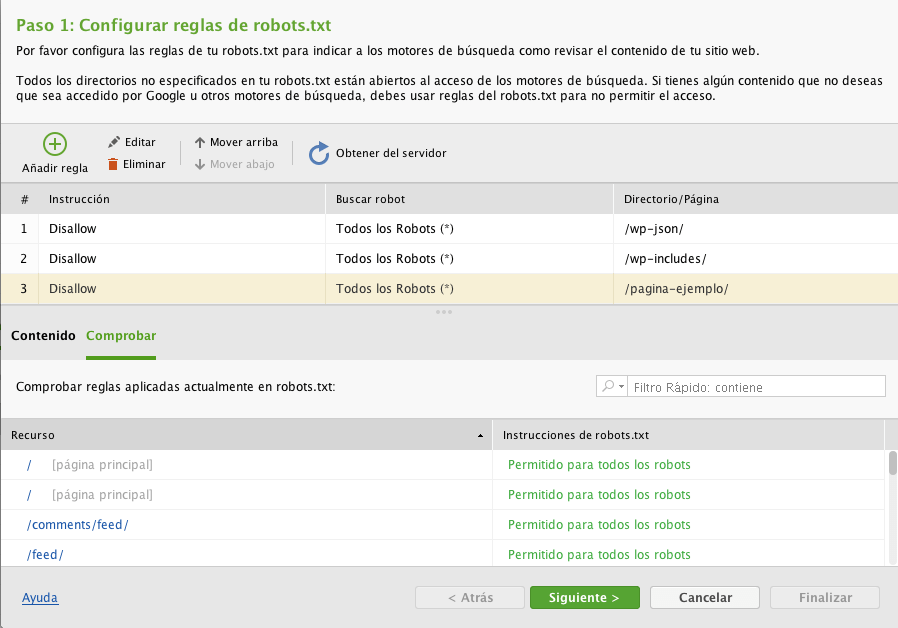

Para el Robots.txt: El robots.txt se compone de reglas, lo más común es añadir reglas de Disallow para evitar el rastreo de ciertos robots, o indicar qué directorios o URLs de nuestro sitio no se deben rastrear. Es importante tener en cuenta que marcar un directorio o URL con la regla Disallow no lo exime de ser rastreado. Si lo que queremos es evitar la indexación de algún contenido debemos etiquetar este con un no-index y así nuestro contenido no aparecerá en las SERPs.

Luego hacemos clic en directorio/página y seleccionamos las carpetas que queremos bloquear.

Vamos añadiendo bloqueos según necesitemos, luego lo guardamos y de nuevo, lo subimos mediante FTP a la raíz de nuestro sitio web.

![Curso SEO online – El mejor curso de SEO [2024]](https://cursoseoprofesional.com/wp-content/uploads/2022/01/cropped-cropped-logo-blanco-horizontal_brillo.png)